🛰️ Introducción

El cluster Ragnar es una infraestructura de cómputo de alto rendimiento (HPC) desarrollada por el Instituto de Astrofísica de la Universidad Andrés Bello. Está diseñado para facilitar simulaciones, análisis de datos y proyectos complejos en astronomía y física, especialmente para estudiantes, investigadores y colaboradores.

💻 Recursos del Cluster

Nodos de cómputo:

- 6 nodos dedicados a simulaciones y análisis.

- Total de 136 núcleos de CPU.

- 1.28 TB de memoria RAM.

| Nodo | Núcleos | Memoria (GB) |

|---|---|---|

| ragnar01–02 | 28 | 128 |

| ragnar03–06 | 20 | 256 |

Sistema operativo: CentOS (migración a Rocky Linux en curso)

Gestor de recursos: SLURM

📂 Almacenamiento

/mnt/nfs1: espacio compartido, con respaldo diario. Ideal para código y scripts./scratch: almacenamiento local de alto rendimiento. No se respalda y se purga regularmente.

Recomendaciones:

- Guarde resultados importantes en

/mnt/nfs1. - Use

/scratchpara datos temporales. - Elimine archivos innecesarios para evitar eliminación automática.

🔐 Acceso y Solicitud de Cuenta

Solicitar CuentaRequisitos del formulario:

- Nombre, correo institucional, RUT/pasaporte, universidad y facultad.

- Detalles técnicos del proyecto.

- Software necesario y necesidades de almacenamiento.

- Aceptación de políticas de uso.

Conexión vía SSH:

ssh usuario@172.20.1.138

🧰 Entorno de Software

Lenguajes disponibles: Python, Julia, MATLAB, R

Software astronómico: Astropy, IRAF, DS9, SExtractor

Visualización: ParaView, Matplotlib, Gnuplot

Utilidades: MPI, Git, CUDA, CMake

Se utiliza Lmod para cargar módulos de software y EasyBuild para su instalación reproducible.

Comandos útiles:

ml av # Ver módulos disponibles

ml spider python # Buscar módulo

ml Python/3.11.3 # Cargar módulo

ml unload Python/3.11.3 # Descargar módulo

ml purge # Descargar todos los módulos

📋 SLURM y Gestión de Trabajos

SLURM organiza y gestiona los recursos del cluster. La partición por defecto es LocalQ.

Script de ejemplo: 1 tarea, 20 núcleos

#!/bin/bash

#SBATCH --job-name=python20

#SBATCH --partition=LocalQ

#SBATCH --ntasks=1

#SBATCH --cpus-per-task=20

#SBATCH --mem=100G

#SBATCH --time=08:00:00

#SBATCH --output=python20_%j.out

module load python/3.11.3

srun python my_script.py

Comandos frecuentes:

sinfo # Ver estado de nodos

squeue # Ver trabajos en cola

sbatch script.sh # Enviar trabajo por lote

srun --pty bash # Sesión interactiva

scancel <jobid> # Cancelar trabajo

sacct # Consultar trabajos finalizados

🧬 Paralelismo

El cluster soporta tres tipos de paralelismo:

- MPI: múltiples procesos independientes (paralelismo entre nodos).

- OpenMP: hilos en un único proceso (paralelismo dentro del nodo).

- Híbrido: combinación de MPI + OpenMP.

Ejemplo híbrido:

sbatch --ntasks=4 --cpus-per-task=7 --mem=48G --time=2:00:00 script.sh

🖥️ Aplicaciones Gráficas (ThinLinc)

ThinLinc permite el uso de aplicaciones gráficas como DS9 o TOPCAT desde el cluster, sin necesidad de transferir archivos.

Ventajas:

- Visualización remota de grandes volúmenes de datos.

- Sesiones persistentes.

- Acceso a interfaz gráfica desde cualquier computador.

Importante: no ejecutar simulaciones pesadas en ThinLinc; solo usar SLURM para eso.

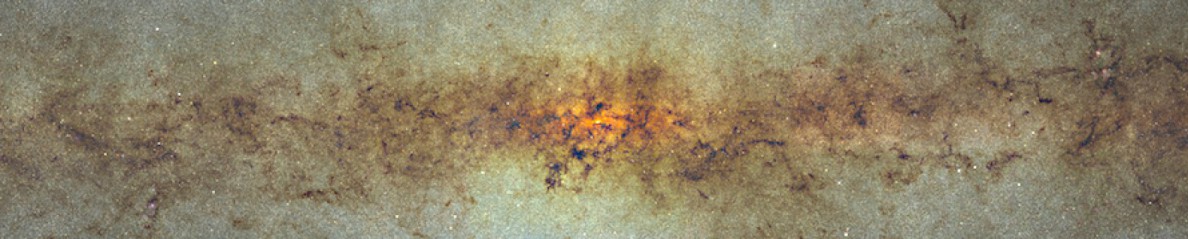

🌌 Casos de Uso en Astrofísica

- Simulación de formación de galaxias y cúmulos.

- Modelado de ondas gravitacionales.

- Procesamiento de catálogos y detección de eventos transitorios.

- Comparación de rendimiento entre laptop y cluster.

📢 Soporte y Comunidad

- 📄 Documentación y formulario: disponible en esta misma página.

- 📧 Soporte técnico: ia_cluster@unab.cl

- 🎓 Capacitación: el Instituto ofrece talleres y cursos sobre HPC y astrofísica computacional.

Reconocimientos / Acknowledgements

Para toda publicación científica (artículos, tesis, pósters, informes) que utilice recursos del cluster Ragnar, solicitamos incluir una mención de reconocimiento. Puede elegir una de las siguientes frases en inglés:

- “This work made partial use of the RAGNAR computer server at Universidad Andrés Bello for calculations.“

- “The computations were carried out using the RAGNAR computer server at Universidad Andrés Bello.“

Recomendación: añada esta mención en la sección de Agradecimientos (Acknowledgements).

Sugerencia adicional: al publicar, por favor envíe el DOI o referencia al equipo de soporte en ia_cluster@unab.cl para registro de impacto.